De la Inteligencia Artificial al retorno al ser humano

Autor: Francesc Mir Giménez

Índice

1. Introducción

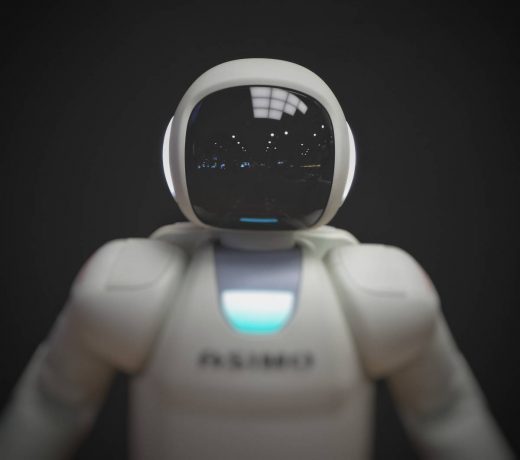

Parece difícil de creer el inmenso impacto que va a tener la Inteligencia Artificial (IA). En 1995 poca gente preveía el desarrollo futuro de internet. En 2007, Apple lanzó su iPhone y pocos imaginaban las inmensas repercusiones que tendría.

Sin embargo, en un futuro no muy distante, la IA será nuestro asistente personal, nuestro amigo. Responderá nuestras preguntas, ayudará a educar a nuestros hijos y estará pendiente de nuestro estado de salud. Nos enviará las compras a la puerta de casa y nos llevará autónomamente de un punto a otro. Será nuestra interface a un mundo mucho más complejo. Será tan omnipresente que se convertirá en invisible.

2. Historia de la IA

2.1. Orígenes de la IA.[1]

Entre las notas de Ada Lovelace, matemática y escritora, se encuentra lo que se reconoce hoy como el primer algoritmo destinado a ser procesado por una máquina. Un algoritmo es un conjunto ordenado de operaciones que permite hacer un cálculo. A Lovelace se la considera la primera programadora de la historia.

Pero es a Alan Turing a quien se considera padre de la inteligencia artificial. En 1936, este visionario diseñó una máquina capaz de implementar cálculos que hubieran sido formalmente definidos.

Posteriormente fue en 1956 cuando, durante la conferencia de Darthmounth, se acuñó el término Inteligencia Artificial para referirse a “la ciencia e ingenio de hacer máquinas inteligentes”.

2.2. El avance de la IA [2]

A pesar de las expectativas iniciales, las investigaciones sobre inteligencia artificial retrasaron su desarrollo hasta la década de los 90, cuando muchas empresas tecnológicas decidieron realizar inversiones con el fin de procesar la enorme cantidad de datos que se generan en el mundo digital.

Se enumeran algunos de los hitos más relevantes:

- El ordenador Deep Blue de IBM consiguió en 1997 ganar al maestro Gary Kasparov al ajedrez.

- En 2005 un coche autónomo circula 212 kilómetros a través del desierto sin apoyo humano.

- En 2011 el ordenador Watson, también de IBM, ganó a humanos en el concurso de conocimientos Jeopardy.

- En 2014 por primera vez un ordenador superó el test de Turing.

- En 2016 Microsoft lanza en Internet a Tay, una IA que chatea (un chatbot), capaz de aprender a partir de la interacción con las personas.

- El mismo año AlphaGo vence al campeón mundial del juego Go.

- En 2017, Libratus se impone a rivales humanos en un torneo múltiple de póker.

2.3. La IA simbólica [3]

Los primeros programas que jugaban al ajedrez empleaban reglas rígidas creadas por programadores. Durante mucho tiempo, los expertos creyeron que la IA con nivel humano podría alcanzarse creando un conjunto de reglas lo suficientemente grande para manipular el conocimiento. Este enfoque es conocido como IA simbólica y dominó desde 1950 hasta finales de los 80.

El ordenador DeepBlue, campeón de ajedrez, es un ejemplo de esta tecnología. Deep Blue fue una victoria de la capacidad de computación, algoritmos específicos y la posibilidad de acceder a millones de jugadas previamente registradas.

Aunque la IA simbólica probó ser adecuada para resolver problemas lógicos y bien definidos, fue incapaz de resolver problemas mucho más complejos, como la clasificación de imágenes, el reconocimiento de voz y la traducción entre lenguajes naturales.

2.4. Machine learning o Aprendizaje Automático (AA)[4]

Un nuevo enfoque surgió entonces para tomar el lugar de la IA simbólica: El Machine Learning o Aprendizaje Automático (AA).

¿Puede un ordenador ir más allá de lo que le ordenamos hacer y aprender por sí mismo cómo realizar una tarea específica? Los humanos ya no diseñan reglas para procesar datos y así obtener respuestas a la salida del programa. Con el AA los humanos pasan los datos y las respuestas esperadas con el fin de que el sistema obtenga las reglas. Estas reglas pueden ser luego aplicadas a nuevos datos para producir nuevas respuestas.

Para realizar el AA necesitaremos de tres ingredientes fundamentales: unos datos de entrada, ejemplos de lo que se espera como salida y una forma de medir si la tarea está bien realizada. El sistema de AA es “entrenado” en vez de ser “programado”.

2.5. Deep learning o Aprendizaje profundo (AP)[5]

Una representación es una forma diferente de presentar los datos. Lo que hace el AA es encontrar representaciones para los datos de entrada que nos acercan más a la predicción de las salidas esperadas.

El Deep Learning o Aprendizaje Profundo (AP) es un subcampo del AA. Se aplican representaciones de manera sucesiva mediante lo que se denominan capas. Los nuevos modelos tienen en su interior cientos de capas repletas de representaciones. Estas representaciones son entrenadas con los datos que se van cargando. Este proceso de entrada y salida se repite millones de veces en lo que se denomina bucle de aprendizaje.

Estas representaciones por capas mayoritariamente se construyen mediante redes neuronales. La red neuronal consiste en un conjunto de unidades, llamadas neuronas artificiales, conectadas entre sí para transmitirse señales. La información de entrada atraviesa la red neuronal produciendo unos valores de salida.

2.6. AlphaGo[6]

La aplicación práctica de todo ello fue AlphaGo, que representa la unión de las capacidades de: computación, memoria, aprendizaje y acceso a base de datos.

Se ha llegado a afirmar que el juego de Go tiene más combinaciones posibles que la cantidad de átomos que hay en el universo. Su complejidad es tal que más que aprender a jugarlo los campeones dedican su vida a aprender a intuirlo. AlphaGo derrotó en 2016 al campeón mundial, Lee Sedol, en un torneo con reglas oficiales.

AlphaGo se nutrió al principio de centenares de miles de partidas registradas. Y luego empezó a mejorar jugando sin cesar contra sí mismo, prescindiendo del conocimiento humano y creando jugadas desconocidas. En 2018, AlphaZero, evolución de AlphaGo, tardó 9 horas en convertirse en el mejor jugador de ajedrez del mundo y 13 días en el mejor jugador de Go.

A pesar de ello, a diferencia de un ser humano, AlphaZero no sabe que está jugando al Go. AlphaZero aún cuenta con una inteligencia artificial “débil”.

3. Inteligencia Artificial y Consciencia

3.1. IA débil vs IA fuerte: el dilema cuerpo/mente

La afirmación de que las máquinas pueden actuar como si fuesen inteligentes, simulando el pensamiento, es denominada la hipótesis de la IA débil, mientras que la afirmación de que las máquinas realmente pueden llegar a pensar se denomina la hipótesis de la IA fuerte.[7]

Se presuponía a que con el tiempo, la distinción entre IA débil y fuerte se disolvería. Sin embargo, puede ser posible simular el comportamiento humano, pero las cuestiones referidas a la autoconciencia, el conocimiento (saber qué se sabe), las emociones o la intencionalidad son cruciales en cualquier acercamiento a la naturaleza humana.

Todo ello se relaciona con el llamado dilema cuerpo-mente. El filósofo y matemático René Descartes se preguntaba en el siglo XVII si las máquinas podrían llegar a pensar. Descartes postuló que en el universo hay dos tipos de substancias: la material (res extensa o sustancia extensa) y la mental (res cogitans o sustancia mental); relacionadas entre sí, pero no explicables una desde la otra. Schopenhauer hace una distinción similar entre sujeto y objeto.

3.2. IA e Inteligencia

Durante el siglo XX, psicólogos y científicos, ante la dificultad de encontrar una definición para la inteligencia, se focalizaron en concretar metodologías para su medición. Es aquí donde encontramos muchas teorías, como la de la inteligencia cristalizada y fluida de Raymond Cattell, la de la teoría bifactorial de Spearman o la de las inteligencias múltiples de Howard Gardner.[8]

Medir la inteligencia significa establecer criterios de comparación. Esto puede ser muy útil. Pero ser capaz de medir la inteligencia no significa saber exactamente lo que es.

3.3. El enigma de la habitación china

Reproducir o imitar resultados de pensar no es pensar.

El enigma del cuarto chino ejemplifica el problema. Colocamos a un inglés (que no comprende el chino) en un cuarto cerrado, donde se encuentran símbolos en chino, e instrucciones en inglés de cómo manipular esos símbolos. Por una rendija, científicos chinos le dan al inglés instrucciones en chino, las cuales no comprende, pero guiándose por las instrucciones que tiene en inglés, manipula los símbolos que tiene en el cuarto de forma tal que obtiene una respuesta correcta en chino.

El argumento del cuarto chino suena muy convincente. Pero uno puede conducir un automóvil sin necesidad de saber mecánica. ¿Por esta razón no puede conducir? No. Los niños pueden utilizar ordenadores sin la necesidad de tener conocimiento alguno acerca de microprocesadores. No necesitamos saber qué es el amor para poder amar, ni necesitamos saber qué es la vida para poder vivir.

3.4. El test de Turing

Turing en 1950 propuso una prueba para determinar si una máquina era inteligente. Se interroga separadamente a un hombre y a una máquina. Si el interrogador confunde a la máquina con el hombre, la máquina es inteligente.

En el año 2014, un programa de ordenador fue capaz de convencer al 33% de los jueces que estaban chateando con un niño ucraniano de 13 años, superando la prueba.[9]

Nótese que no importa cómo funciona la máquina, con tal de que reproduzca el comportamiento humano. La inteligencia no se tiene, se exhibe. Si no se puede comprender el funcionamiento de la inteligencia, solo se puede juzgar la inteligencia a partir de las acciones.

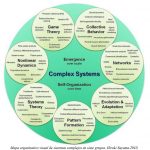

3.5. La inteligencia como comportamiento adaptativo

Como se ha comentado, a mediados de los ochenta los investigadores vieron que la inteligencia de los sistemas basados en el conocimiento, la denominada Inteligencia simbólica, no podían simular tareas que realizaban de manera innata todos los animales. Un animal exhibe inteligencia en su comportamiento adaptativo. De la misma forma, un sistema se considerará inteligente si puede adaptarse a su medio. Cómo lo haga no es la cuestión principal.

Empezaron entonces a modelar sistemas inspirándose en el comportamiento. Una consecuencia de ello es la aparición de los sistemas de AA mencionados.

Emulando los postulados de la selección natural de Charles Darwin, a los sistemas basados en el comportamiento, como los de AA, se les aplican estrategias de evolución. Una estrategia de evolución es un algoritmo que genera versiones del sistema con cierta aleatoriedad para producir la siguiente generación basándose en las versiones más fuertes. El proceso iterativo de seleccionar las más fuertes y producir la siguiente generación produce cada vez mejores resultados.[10]

3.6. IA y Consciencia

Así, concluimos que las máquinas ya se comportan como si tuviesen inteligencia. Pero ¿llegarán a saber que la tienen? ¿Serán autoconscientes?

Desde los descubrimientos del matemático Kurt Gödel en 1931 se ha desarrollado toda una línea crítica respecto a la posibilidad de que la computación nos lleve a una verdadera inteligencia consciente. El teorema de completitud de Gödel demuestra que existen verdades accesibles a la mente humana que quedan fuera de lo que puede construirse con un algoritmo.[11]

El físico y matemático Roger Penrose separa el mundo matemático, el físico y el psíquico. Entiende que mente y cuerpo son dos realidades separables, readaptando los postulados de Descartes. Hay aspectos en la mente que se escapan al determinismo de la física convencional.[12]

No se percibe en las máquinas la aparición de consciencia pero en gran parte de nuestro cuerpo tampoco y, sin embargo, controla nuestra existencia. Hay formas de consciencia en los animales y en nuestro entorno que no hemos sido capaces de percibir.

Es más fácil, estadísticamente hablando, producir cerebros humanos como una fluctuación aleatoria de nuestro sistema solar que llevar a cabo todo el proceso evolutivo. Esta es la llamada paradoja de Boltzmann[13]. Parece evidente el patrón de causalidad que se da en la historia observable del universo. Es difícil no apreciar una direccionalidad y un ajuste fino para hacerlo globalmente habitable. Debe haber alguna ley, que desconocemos, detrás de la misma evolución del universo y, por tanto, del hombre y de su consciencia.

¿Es la naturaleza por sí sola la que hace que emerjan capacidades superiores como la consciencia? Estamos perdiendo parte de la fuerza del argumento de los defensores de la IA fuerte. Es la evolución de la naturaleza y no nuestra propia inteligencia la que podría hacer emerger una verdadera inteligencia consciente.

4. Los retos de la IA

4.1. Las emociones

La inteligencia artificial empieza también a contar con eso que ha venido a llamarse inteligencia emocional. Un atajo y complemento para la racional. Se están desarrollando sistemas que se adaptan y anticipan a las emociones humanas. También pueden empatizar con las personas que interactúan con ellos. Puede que, en el futuro, las máquinas lleguen incluso a desarrollar nuevas emociones que nos son desconocidas.[14]

4.2. La moral

Es cuestión de tiempo que las IA lleguen a tomar decisiones sobre quién sobrevive en un accidente, si el humano lleva el arma con intención agresiva o si se puede conceder un préstamo o un seguro médico a un solicitante.

Eso sin contar con las consecuencias de la evolución autónoma de los propios sistemas. Conviene recordar lo que ocurrió con Tay, el chatbot que Microsoft puso a chatear en 2016. En apenas unas horas, Tay pasó de ser una amena compañera de charla a convertirse en una auténtica xenófoba y homófoba.[15]

Es evidente que la moralidad que se integre en las IA será de origen humano, al menos de momento. Las máquinas reflejarán la moral y prejuicios del programador.

5. La IA y el ser humano

5.1. La evolución tecnológica

La ley de Moore expresa que aproximadamente cada dos años se duplica el número de transistores en un microprocesador. Raymond Kurzweil, inventor y científico, extiende la ley de Moore para describir un crecimiento tecnológico del progreso tecnológico en lo que se denomina la ley de rendimientos acelerados. Todo está ya ligado: digitalización, inteligencia artificial, interconexión, automatización, robotización y datos masivos.

Para Kurzweil: “La inteligencia artificial alcanzará los niveles humanos alrededor de 2029, pero un poco más adelante, en 2045, habremos multiplicado la inteligencia biológica humana mil millones de veces”.[16]

5.2. La fusión hombre y máquina

En el año 2014 fue posible la primera comunicación directa entre cerebros humanos a 7800 km de distancia[17]. Los ordenadores, en un futuro no muy lejano, podrán interactuar directamente con el cerebro humano de una forma fluida.

Elon Musk, director general de Tesla, tiene entre sus múltiples compañías a Neuralink, una empresa que crea interfaces entre máquinas y cerebros. Su primera meta es ayudar a aliviar condiciones médicas crónicas. Neuralink planea implantar antes de una década su primer microprocesador en un ser humano para «aumentar» a los seres humanos aprovechándose del poder que alcanzará la IA. Quiere «fundir» a las máquinas con los cerebros para lograr «algún tipo de simbiosis con la inteligencia artificial».[18]

No es el único proyecto en esta línea. La vanguardia del pensamiento tecnológico de Silicon Valley, que ha pasado a denominarse transhumanismo, cree que debemos utilizar la tecnología para crear un modelo de humano muy superior.[19]

5.3. El transhumanismo

El transhumanismo emergente en Silicon Valley conviene en que el Homo Sapiens, tal como lo conocemos, está terminando su recorrido histórico.

Edward Fredkin, un ilustre gurú de la IA, lo valora como uno de los tres grandes hitos de la historia del universo. El primero fue el origen del mismo, el segundo la aparición de la vida, y el tercero el advenimiento de la IA. La ve como un paso hacia una relación final entre la creación y lo creado.[20]

Otro gurú de la IA, Earl Cox, considera que estamos en el crepúsculo de la civilización humana y en el amanecer de una nueva supercivilización que llegará a un sistema combinado de mentes, una Mente global.[21]

No es tan obvio que sea algo tan bueno trascender la condición humana. Dicha trascendencia tecnológica parte de la noción de que los humanos somos reductibles a nada más que objetos de procesamiento de información. Pero la trascendencia no solo implica superar el sufrimiento y la muerte; implica también trascender el cuerpo, la interdependencia, la vulnerabilidad y la complejidad.

¿No deberíamos aprender realmente lo que es ser humano antes de trascender nuestra humanidad?. Porque si no, lo único que probablemente vamos a hacer es repetir nuestros errores más inteligentemente.

5.4 Los riesgos de la IA

El mundo está en crisis, una crisis no solo ecológica de una dimensión nunca antes vista, sino una crisis de sentido.

Las tecnologías digitales no son el resultado inevitable del progreso científico, sino que reflejan las decisiones políticas y empresariales tomadas. No obstante los sesgos que se le incrusta, se declara que la tecnología es neutral. Cada vez veremos más a los seres humanos como el problema y a la tecnología como la solución.

Los estados y las empresas se están gastando miles de millones en tecnología. La tendencia mayoritaria que prevalece es la búsqueda de eficiencia y la reducción de costes. No es difícil prever que la suma de inteligencia artificial y robótica van a provocar un vuelco en el mercado laboral, ahondando en la creciente desigualdad económica.

La humanidad se dirige hacia un futuro en el que la vigilancia masiva permite un seguimiento permanente y donde los datos personales de la población son expuestos. Los ciudadanos se vuelven más visibles para los gobiernos y las corporaciones, pero no al revés.

Los desarrollos tecnológicos responden a intereses comerciales. El interés público es lo de menos cuando las inteligencias artificiales tienen logotipo. En el caso de que se llegue a la superinteligencia, no habrá una sola: habrá varias lideradas por diferentes empresas con sus propios intereses.

En la época en que vivimos, el hombre es reducido a información. La visión científica es sumamente poderosa pero esta visión no está completa, especialmente porque no tenemos un modelo científico mínimamente aceptable de lo que es realmente la consciencia, lo cual significa que realmente no sabemos quiénes somos.

La cuantificación de la experiencia humana y la apuesta por las máquinas ponen en riesgo aquellas cualidades más importantes de la vida humana encarnada en el mundo: el amor, la compasión, la voluntad…

Es preciso humanizar la tecnología, ponerla al servicio de las personas. Esto puede sonar ingenuo, pero quizá sea la única posibilidad que tenemos si no queremos llegar a un escenario distópico como el que constantemente imagina la ciencia ficción, o como el que ya ha planteado Yuval Noah Harari en su popular libro de no-ficción Homo Deus[22]. En todas estas distopías siempre hay una primera víctima: la posibilidad de decidir nuestro destino.

Puede que la IA en un futuro no muy lejano nos ayude a convertirnos en superinteligentes. Pero ser superinteligente no significa ser superhumano. Ser humano es mucho más que eso.

Frente a los designios divinos, el Renacimiento colocó al hombre en el centro de las cosas. Hoy, frente a los riesgos de la tecnología, la única solución viable quizás sea hacer lo mismo.

Bibliografía

agenciasinc.es (2014). Demostrada la comunicación directa entre cerebros humanos a 7.800 kilómetros de distancia. Recuperado en https://www.agenciasinc.es/Noticias/Demostrada-la-comunicacion-directa-entre-cerebros-humanos-a-7.800-kilometros-de-distancia [obtenido en 10 de enero de 2020].

Darlington, K (2018). Sistemas de inteligencia artificial que gestionan emociones humanas. BBVAopenmind.com. Recuperado en https://www.bbvaopenmind.com/tecnologia/inteligencia-artificial/sistemas-de-inteligencia-artificial-que-gestionan-emociones-humanas/ [obtenido en 10 de enero de 2020].

elmundo.es (2016). Una inteligencia artificial se vuelve racista, antisemita y homófoba en menos de un día en Twitter. Recuperado en https://www.elmundo.es/tecnologia/2016/03/28/56f95c2146163fdd268b45d2.html. [obtenido en 10 de enero de 2020].

espaciohumano.com (2013). Inteligencia y vida artificial. Recuperado en https://espaciohumano.com/inteligencia-y-vida-artificial/ [obtenido en 10 de enero de 2020].

europapress (2016). La inteligencia artificial alcanzará a la humana en 2029. Recuperado en https://www.europapress.es/ciencia/laboratorio/noticia-inteligencia-artificial-alcanzara-humana-2029-20160509123602.html [obtenido en 10 de enero de 2020].

fronterasCTR (2108). La Inteligencia Artificial vista desde la filosofía y la teología. Recuperado en https://blogs.comillas.edu/FronterasCTR/2018/12/19/la-inteligencia-artificial-vista-desde-la-filosofia-y-la-teologia/ [obtenido en 10 de enero de 2020].

Hernández, M.T. (2015). Teorías de la inteligencia. es.slideshare.net. Recuperado en https://es.slideshare.net/mitzimarlettehernandez/teorias-de-la-inteligencia [obtenido en 10 de enero de 2020].

Infobae.com (2018). ¿Quiénes son los transhumanistas y por qué menosprecian a los humanos?. Recuperado en https://www.infobae.com/tendencias/innovacion/2018/04/15/quienes-son-los-transhumanistas-y-por-que-menosprecian-a-los-humanos/ [obtenido en 10 de enero de 2020].

Latorre, J.I. (2019). Ética para máquinas. Barcelona: Editorial Planeta.

Méndez, M.A. (2014). Un ordenador supera por primera vez el test de Turing. Gizmodo.com. Recuperado en https://es.gizmodo.com/un-ordenador-supera-por-primera-vez-el-test-de-turing-1587840827 [obtenido en 10 de enero de 2020].

Merino, M. (2018). Elon Musk dice que su compañía Neuralink tendrá la tecnología para fusionar cerebros humanos con máquinas en una década. Recuperado en https://www.xataka.com/robotica-e-ia/elon-musk-dice-que-su-compania-neuralink-tendra-tecnologia-para-fusionar-cerebros-humanos-maquinas-decada [obtenido en 10 de enero de 2020].

tendencias21.net (2017). Penrose sienta las bases de una biofísica cuántica de la mente. Recuperado en https://www.tendencias21.net/Penrose-sienta-las-bases-de-una-biofisica-cuantica-de-la-mente_a1406.html [obtenido en 10 de enero de 2020]

Webedia Brand Services (2019). Los principales hitos en la historia de la inteligencia artificial. Recuperado en https://iahuawei.xataka.com/principales-hitos-historia-inteligencia-artificial/ [obtenido en 10 de enero de 2020]

Yuval Noah Harari (2017). Homo Deus. Madrid: Debate.

Notas

[1] Webedia Brand Services, 2019

[2] Webedia Brand Services, 2019

[3] Latorre, 2019

[4] Latorre, 2019

[5] Latorre, 2019

[6] Latorre, 2019

[7] Latorre 2019

[8] Hernández, 2015

[9] Méndez, 2014

[10] Latorre, 2019

[11] tendencias21.net, 2017

[12] tendencias21.net, 2017

[13] fronterasCTR, 2018

[14] Darlington, 2018

[15] Elmundo.es, 2016

[16] Europapress, 2016

[17] agenciasinc.es, 2014

[18] Merino, 2018

[19] Infobae.com, 2018

[20] Espaciohumano.com, 2013

[21] Espaciohumano.com, 2013

[22] Yuval Noah Harari, 2017

Deja una respuesta